„Vorhersagen sind schwierig, besonders, wenn sie die Zukunft betreffen.“

Mark Twain (1835-1910), amerikanischer Schriftsteller

Die große Herausforderung einer Wettervorhersage ist die Abbildung des chaotischen Zustandes der Atmosphäre zu einem Zeitpunkt in der Zukunft. Mathematisch gesehen kann durch eine minimale Änderung im Anfangszustand der Unterschied in den Endzuständen fast beliebig groß werden. Auch wenn man den Anfangszustand genau kennt, kann man einen Zeitpunkt in der Zukunft nur mit einer bestimmten Wahrscheinlichkeit vorhersagen.

Man möchte nun zum Beispiel wissen ob es an einem Ort morgen regnen wird oder nicht. Neben den lokalen Gegebenheiten am Ort selbst, ist die Frage, wie sich ein Wettersystem über die Zeit fortbewegt, d.h. wo es entsteht und welchen Weg es einschlägt. Diese Wettersysteme, oder Großwetterlagen bestimmen das Wettergeschehen in unserer Region.

Wir stellen uns nun ein Modell aus einer Rutsche und einer bestimmten Anzahl von Murmeln vor. Die Rutsche platzieren wir am Ort der Entstehung des Wettersystems, zum Beispiel vor der Ostküste von Grönland. Danach lassen wir 100 Murmeln nacheinander die Rampe herunterrollen, und beobachten ihren Weg Richtung Europa. Jede Murmel wird sich etwas anders fortbewegen, weil jeder Vorgang durch kleine Störungen des Systems, zum Beispiel eine kleine Änderung der Anfangsgeschwindigkeit, ein Luftzug oder eine Unebenheit des Bodens etwas anders ist. Diese Wiederholung von Vorgängen nennt man ein Ensemble. Jede Murmel, sprich jedes simulierte Wettersystem, würde dann in einem Bereich um unseren gedachten Ort auftreffen. Somit können wir nur eine Wahrscheinlichkeit angeben, mit welcher uns das Wettersystem treffen wird, also mit welcher Wahrscheinlichkeit mit Regen zu rechnen ist. Die Genauigkeit einer Vorhersage hängt auch von der Art der Wetterlage ab. So ist zum Beispiel ein stabiles Hochdruckgebiet für die Wettervorhersage relativ einfach zu erfassen, weil es eine eher ruhige Wetterlage beschreibt. Eine Ausnahme bildet die lokale Vorhersage von Nebel, weil dessen Ausbildung sehr sensibel auf die Temperatur und Feuchte reagiert und sehr geringe Abweichungen im Modell bereits zu einer Auflösung oder Bildung führen können. Dieser Punkt wird in einem anderen Blogbeitrag näher erklärt.

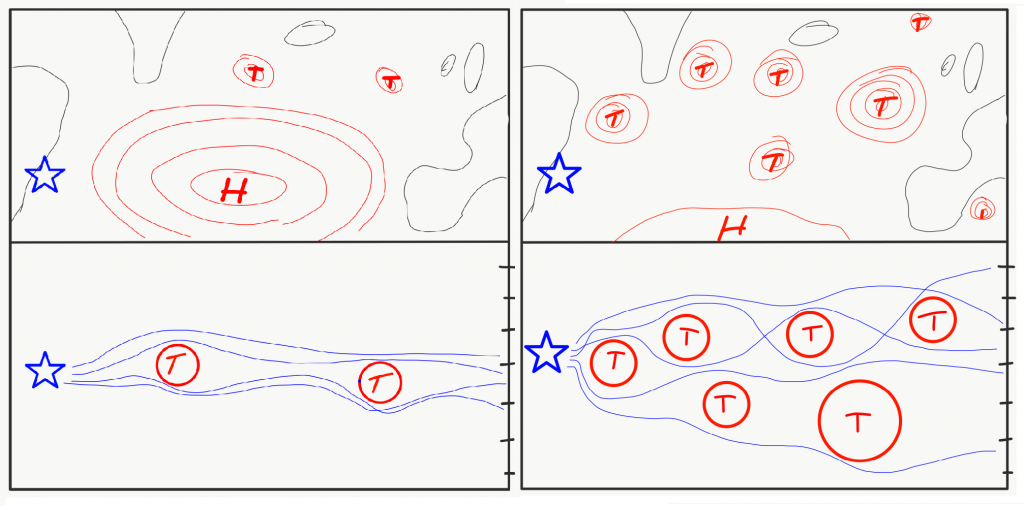

Wieso die Ausbildung von Hoch- und Tiefdruckgebieten über dem Nordatlantischen Ozean wichtig ist für die Genauigkeit der Wettervorhersage in Deutschland zeigt folgende Skizze:

© Philipp Reutter, Joachim Fallmann

Dafür kommen wir wieder zu dem Murmel-Modell zurück. Dieses Mal ist die Murmel aus Holz und rollt in einem strömenden Bach – der Bach soll die Atmosphäre darstellen, der blaue Stern den Beginn der Rampe. Nun wird sich die Murmel (ein Luftpaket) umso chaotischer durch den Bach fortbewegen je mehr Steine den Weg blockieren (rechtes Bild). Die Lage des Endpunktes schwankt dann weniger (links) oder mehr (rechts). Die Skala auf den jeweils rechten Seiten könnte z.B. die vorhergesagte Temperatur oder die Regenmenge an unserem gedachten Ort sein. Außerdem hängt die Bahn der Murmel auch noch von den Anfangsbedingungen, also der Lage der Rampe und von der Startgeschwindigkeit der Murmel ab. Ein ziemliches Chaos…

Hier wollen wir nun einen kurzen Ausflug in die Chaostheorie machen und erklären, was ein Schmetterling mit der ganzen Sache zu tun hat.

Im Jahre 1963 veröffentlichte der amerikanische Meteorologe Edward Lorenz seine wegweisende Forschung. Er untersuchte dabei meteorologische Phänomene in einem sehr vereinfachten Modell. Er wollte konvektive Zellen – ähnlich den aufsteigenden Luftblasen in einem Topf mit kochendem Wasser – untersuchen. Dabei stieß Lorenz jedoch auf ein merkwürdiges Problem. Als er die Startwerte eines Parameters seiner Simulation nur minimal änderte, von 0,506127 auf 0,506, erhielt er dramatisch andere Ergebnisse aus seinen Computerberechnungen. Er schloss daraus, dass in einem chaotischen System, wie es das Wetter auf der Erde ist, eine geringfügige Abweichung des beim Modellstart eingegebenen Grundzustands zu völlig anderen Ergebnissen führen kann. Er verglich dies mit dem Flügelschlag eines Schmetterlings in Brasilien, der einen Tornado in Texas auslösen könnte. Lorenz – obwohl oftmals so wiedergegeben – meinte damit nicht, dass der Flügelschlag eines Schmetterlings eine Kaskade von Folgeereignissen auslöst, die irgendwann in finaler Konsequenz in der Ausbildung eines Tornados gipfelt.

Vielmehr wollte Lorenz mit dieser Metapher zum Ausdruck bringen, dass der Flügelschlag eines Schmetterlings den Grundzustand der Atmosphäre an einem bestimmten Ort minimal beeinflussen kann, sodass in der Folge die Voraussetzungen zum Beispiel für die Ausbildung eines verheerenden Windsystems im Süden der USA begünstigt werden könnten. Gleichwohl können sich diese Voraussetzungen durch eine minimale Änderung des Grundzustandes auch verschlechtern.

Ändert man für den Wiederholungsversuch in unserem Gedankenexperiment also den Startpunkt der Murmel nur um ein winziges Stück, so wird der Ball nach einer erneuten Reise über den Bach mit sehr hoher Wahrscheinlichkeit nicht an derselben Stelle herauskommen. Mathematisch gesehen kann durch eine minimale Änderung im Anfangszustand der Unterschied in den Endzuständen fast beliebig groß werden. Die Unsicherheit hängt darüber hinaus auch von der Anzahl und Größe der Steine ab. In einem Bach mit wenig Steinen, wächst die Unsicherheit langsamer als in einem Bach mit vielen Steinen.

Aufnahme vom Uni-Campus Mainz Blickrichtung Frankfurt (c) Joachim Fallmann

Neben der Entwicklung der Großwetterlage spielen aber auch noch kleinräumige Unterschiede wie z.B. Landnutzung oder Topographie eine Rolle für die Ausprägung des Wetters an unserem Ort. So kann es zum Beispiel dazu kommen, dass ein Modell für eine Region viel Niederschlag vorhersagt, aber sich zwei Orte innerhalb weniger Kilometer in der Realität stark unterscheiden – z.B. Stark- und Nieselregen. Das passiert zum Beispiel, wenn kleine Unterschiede in der Topographie oder der Landbedeckung (das kann z.B. auch eine große Stadt sein) den Weg der Strömung versperren oder umleiten (mehr dazu in einem späteren Blog). Grundsätzlich findet ständig ein Austausch zwischen der Atmosphäre und dem Erdboden statt – sei es durch Niederschlag oder Verdunstung von Wasser am Boden oder durch andere Gase, die durch geophysikalische oder biologische Prozesse in die Atmosphäre freigesetzt werden. Da es jedoch unmöglich ist, alle Zustände (bis auf atomarer Ebene!) zu jeder Zeit mit höchster Präzision zu erfassen und dabei auch noch Austauschprozesse zu berücksichtigen, kann eine Wettervorhersage niemals perfekt sein. Vor allem Prozesse an denen Wolken beteiligt sind, sind im Moment noch nicht komplett verstanden und müssen noch besser erforscht werden.

Wie genau kleinräumigen Unterschiede und Wechselwirkungen berechnet werden können liegt nun in erster Linie an der Auflösung des Modells. Typische horizontale Auflösungen von Modellen in der Wettervorhersage sind im Moment ca. 2 km. Das heißt, das Modell ‚sieht‘ immer einen mittleren Zustand in 2×2 km großen Fenstern, den sog. Gitterzellen. Eine noch höhere Auflösung für die operationelle deutschlandweite Vorhersage erlauben momentane Computer noch nicht. Wenn man sich überlegt was sich in einem Umkreis von 4 km² um einen herum alles befindet, kann man sich vielleicht erklären, warum eine Wettervorhersage nicht immer zu 100% richtig sein kann, sondern nur einen mittleren Zustand beschreibt. Übrigens hat sich die Auflösung der Wettermodelle mit der Weiterentwicklung von Computern und Technologie stetig verbessert. Das aktuelle Wettervorhersagemodell des Deutschen Wetterdienstes (DWD) COSMO-D2 beschreibt die Zustände der Atmosphäre für ganz Deutschland auf einem Modell-Gitter von 2,2 x 2,2 km horizontal und unterteilt die vertikale Ausdehnung der Atmosphäre in 65 Schichten. Im Modell wird Deutschland und seine Nachbarn somit in 30 Millionen Gitterzellen unterteilt. Noch bis 2007 war das Modell LME in Verwendung, mit einer horizontalen Auflösung von 7km und nur 40 Schichten.

Es gilt auch: Je weiter der Blick in die Zukunft, desto unsicherer wird die Vorhersage. Natürlich gilt auch, je mehr Leistung der Computer, desto besser wird die Vorhersage. Man nennt diesen Wert auch Vorhersage- oder Prognosegüte. Bezogen auf Kurzfrist- bzw. Wettervorhersagemodelle des Deutschen Wetterdienstes gilt für die 24h-Vorhersage der Luftdrucktendenz, ein Indikator für die Ausprägung der Großwetterlage eine 98 prozentige Vorhersagegüte. Dabei wird die Genauigkeit die im Jahre 1968 für eine 24-Stunden-Vorhersage erzielt wurde, heute sogar von einer 168 h Vorhersage übertroffen. Bei einer 72h- Vorhersage der aktuellsten Wettervorhersagemodelle kann die mittlere bodennahe Lufttemperatur auf ca. 2°C genau vorhergesagt werden – wobei eine Abnahme von 1°C deutlich andere Folgen haben kann als eine Zunahme von 1°C (z.B. Ausbildung von Nebel). Eine Prognose für die kommende Woche ist heute ungefähr so zuverlässig, wie sie es vor dreißig Jahren für den nächsten Tag war. Die Genauigkeit für das Eintreffen eines Wettereignisses beträgt dabei gut 90% für einen und immer noch 75% für drei Tage. Das ist schon ziemlich gut, wenn man davon ausgeht das Vorgänge in der Atmosphäre vorwiegend chaotisch ablaufen.

Doch noch einmal ein Blick zurück in die Geschichte: Um Ordnung in das Chaos zu bringen, war es im Jahr 1950 der Amerikaner Jule Charney und eine Gruppe von Wissenschaftlern die erstmals versuchten einen Computer für die Wettervorhersage zu verwenden. So entstand die erste 24h Vorhersage für Nord Amerika. Was damals noch ca. 24h Rechenzeit benötigte, dauert heute weniger als 1h. Charneys Computer ENIAC (Electronic Numerical Integrator and Computer) konnte addieren, subtrahieren, multiplizieren, dividieren und Quadratwurzeln ziehen. In einer Sekunde konnte er 300-400 solcher Operationen (sog. Floating Point Operations – Flops) durchführen.

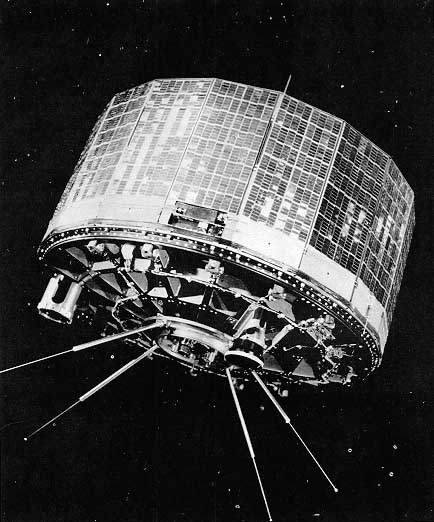

TIROS 1 Satellit

The Goddard Library Extranet [Public domain]

Erstes Fernsehbild des Wetters aus dem All 1960

NASA [Public domain]

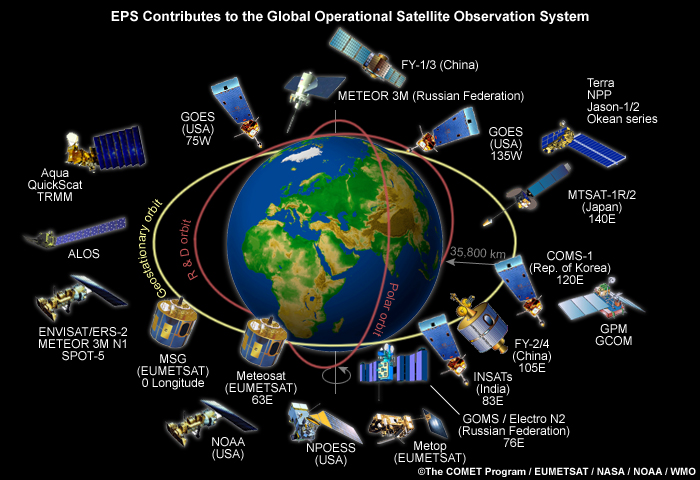

Am 1 April 1960 startete dann mit TIROS 1 einer der ersten Wettersatelliten und lieferte dem Team um Charney erstmals nun auch flächendeckende Daten der Atmosphäre. Wie viele Satelliten leitet sich der Name von einer genaueren Beschreibung ab. Im diesem Fall nämlich von Television and InfraRed Observation Satellite (deutsch: Fernsehkamera- und Infrarotbeobachtungssatellit). Heute schauen ca. 2300 Satelliten auf uns herab (https://www.esa. int/Safety_Security), wovon ca. 30 für Wetter- und weitere ca. 150 für generelle Umweltbeobachtung eingesetzt werden (http://www.wmo.int). Das meteorologische Satellitensystem ist ein von der Weltorganisation für Meteorologie (WMO) koordiniertes globales Wettersatellitenbeobachtungssystem.

Zu den Satellitendaten kommt ein globales Netzwerk aus ca. 11000 Wetterstationen an Land und mehr als 3000 Bojen in unseren Weltmeeren. Zusammen mit globalen Modellen liefern diese Datensätze (sog. Reanalyse) die so wichtigen Randbedingungen für Wettermodelle weltweit. Natürlich reicht der erste Rechner von Charney lange nicht mehr aus um diese Flut an Daten zu bewältigen. Heutige sog. Supercomputer schaffen im Vergleich zu ENIAC 17.000.000.000.000.000.000 (17 Trillionen) dieser Operationen pro Sekunde (17 PetaFlops).

In den kommenden Jahren werden sich Computer wohl noch weiter verbessern und ein noch detaillierteres Bild unserer Erde liefern. Die Vorhersage wird womöglich auch noch genauer werden. Wie sich das aktuelle Wetter allerdings tatsächlich entwickelt, das überlassen wir dann wohl doch besser dem Chaos.